Трансформерные нейронные сети — ОБЪЯСНЕНИЕ! (Внимание — это всё, что вам нужно)

Подпишитесь, чтобы не дать мне заскучать: https://www.youtube.com/c/CodeEmporiu...

БЛОГ: / dataemporium ПЛЕЙЛИСТЫ МОЕГО КАНАЛА ⭕ Обучение с подкреплением: • Reinforcement Learning 101 Обработка естественного языка: • Natural Language Processing 101 ⭕ Трансформеры с нуля: • Natural Language Processing 101 ⭕ Плейлист ChatGPT: • ChatGPT ⭕ Свёрточные нейронные сети: • Convolution Neural Networks ⭕ Математика, которую вы должны знать: • The Math You Should Know ⭕ Теория вероятностей для машинного обучения: • Probability Theory for Machine Learning ⭕ Программирование машинного обучения: • Code Machine Learning КУРСЫ МАТЕМАТИКИ (7-дневный бесплатный пробный период) 📕 Математика для машинного обучения: https://imp.i384100.net/MathML

📕 Математический анализ: https://imp.i384100.net/Calculus

📕 Статистика для науки о данных: https://imp.i384100.net/AdvancedStati...

📕 Байесовская статистика: https://imp.i384100.net/BayesianStati...

📕 Линейная алгебра: https://imp.i384100.net/LinearAlgebra

📕 Вероятность: https://imp.i384100.net/Probability

ДРУГИЕ КУРСЫ ПО ТЕМЕ (7-дневный бесплатный пробный период) 📕 ⭐ Специализация по глубокому обучению: https://imp.i384100.net/Deep-Learning

📕 Python для всех: https://imp.i384100.net/python

📕 Курс MLOps: https://imp.i384100.net/MLOps

📕 Обработка естественного языка (NLP): https://imp.i384100.net/NLP

📕 Машинное обучение в производстве: https://imp.i384100.net/MLProduction

📕 Специализация по науке о данных: https://imp.i384100.net/DataScience

📕 Tensorflow: https://imp.i384100.net/Tensorflow

ССЫЛКИ [1] Основная статья: https://arxiv.org/abs/1706.03762

[2] Tensor2Tensor содержит код с руководством: https://www.tensorflow.org/tutorials/...

[3] Transformer очень интуитивно понятен — потрясающе: http://jalammar.github.io/illustrated...

[4] Блог на Medium с интуитивным объяснением: / what-is-a-transformer [5] Предварительно обученные векторные представления слов: https://nlp.stanford.edu/projects/glove/

[6] Интуитивное объяснение нормализации слоёв: https://mlexplained.com/2018/11/30/an...

[7] Статья, которая показывает даже лучшие результаты, чем трансформеры (Pervasive Attention): https://arxiv.org/abs/1808.03867

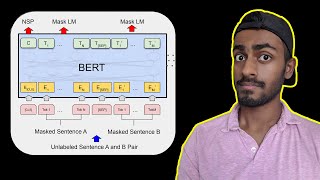

[8] BERT использует трансформеры для предварительной подготовки нейронных сетей для решения распространённых задач обработки естественного языка. : https://ai.googleblog.com/2018/11/ope...

[9] Стэнфордская лекция по рекуррентным нейронным сетям: http://cs231n.stanford.edu/slides/201...

[10] Блог Колы: https://colah.github.io/posts/2015-08...

[11] Википедия о временных рядах событий: https://en.wikipedia.org/wiki/Transfo...)